¿Detectores de IA que fallan a estudiantes reales? El peligro de confiar ciegamente en herramientas AIGC

En los últimos años, con la popularización de herramientas como ChatGPT y Claude, muchas universidades han empezado a implementar detectores de contenido generado por inteligencia artificial (AIGC, por sus siglas en inglés) para evaluar trabajos académicos. En lugares como China, algunas instituciones como la Universidad de Sichuan han anunciado que los estudiantes no podrán graduarse si su tesis supera un cierto porcentaje de “contenido generado por IA”.

Aunque apoyamos el uso responsable de la tecnología, este enfoque levanta una pregunta inquietante: ¿están estas herramientas realmente ayudando o están perjudicando a estudiantes que escribieron sus textos por cuenta propia?

El juicio de la IA sobre la IA: ¿cómo se define lo “humano”?

Muchos detectores de AIGC clasifican como “texto generado por IA” cualquier contenido que parezca demasiado ordenado, estructurado o “demasiado perfecto”. En otras palabras, si un estudiante escribe de forma clara y coherente, corre el riesgo de ser acusado de usar IA.

Por ejemplo, se han dado casos donde textos clásicos de la literatura china, como “El prefacio del pabellón del rey Teng”, fueron etiquetados como 74% generados por IA. Este tipo de errores nos hace cuestionar seriamente los criterios utilizados.

Cómo funcionan (y fallan) los principales detectores de AIGC

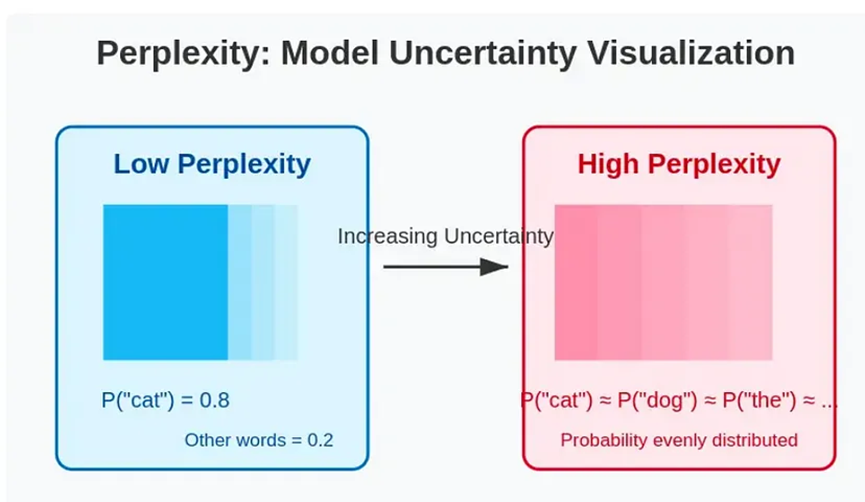

1. Perplejidad y entropía

Estas métricas intentan detectar patrones demasiado “predecibles”, algo común en textos generados por IA. Pero también puede aplicar a textos bien escritos por humanos. Es como decir que alguien “suena demasiado profesional” para haber escrito por sí mismo.

2. Modelos de clasificación basados en machine learning

Estos clasificadores utilizan bases de datos de textos previamente etiquetados como humanos o IA, pero son una caja negra. El estudiante nunca sabe por qué su texto fue marcado. ¿No suena eso a una justicia poco transparente?

3. Análisis de estilo y sintaxis

Analizan estructuras de frases, frecuencia de conectores, longitud media de oraciones, etc. Pero eso no distingue entre un estudiante disciplinado y un chatbot. Peor aún, estudiantes con mejor ortografía y gramática son más fácilmente “sospechosos”.

¿Quién se beneficia del miedo a la IA?

Mientras modelos como DeepSeek pueden procesar un millón de tokens por solo 8 yuanes, algunos detectores como los de CNKI cobran hasta 2 yuanes por revisar 1.000 caracteres. Esto ha creado un negocio rentable a costa del miedo, la confusión y, en muchos casos, la injusticia hacia estudiantes.

¿Prohibir la IA o enseñarla bien?

En lugar de penalizar el uso de IA, universidades como algunas en Estados Unidos han adoptado una metodología educativa más moderna: permiten que los estudiantes creen y usen sus propios modelos de IA como parte del proceso de aprendizaje. Esto les enseña ética, diseño de prompts y pensamiento crítico.

Quizás dentro de unos años, “Lenguaje con IA” sea una materia obligatoria como Matemáticas o Literatura.

La solución: herramientas accesibles y responsables como XXAI

Plataformas como XXAI permiten a los usuarios acceder a modelos avanzados como GPT-4o, Claude 3.7, Gemini 2.5, Perplexity, y más, todo desde una sola interfaz y por solo \$9.9 USD al mes. Esta solución es ideal para estudiantes, creadores de contenido, traductores y cualquier persona que busque aprovechar la IA de forma ética y eficiente.

Con XXAI puedes escribir, revisar, traducir y organizar tus ideas, eligiendo el modelo que mejor se adapte a tu tarea, todo en español y con una interfaz intuitiva.

Conclusión: no se trata de prohibir la IA, sino de educar en su uso

La IA no es el enemigo. El problema está en cómo la usamos, cómo la regulamos y qué tanto confiamos ciegamente en herramientas que, aunque avanzadas, siguen siendo imperfectas.

Si de verdad queremos proteger la integridad académica, debemos educar mejor, no castigar más. Y sobre todo, garantizar que las herramientas sirvan a las personas, no que las juzguen erróneamente.