AMD Advancing AI 2025 : Lancement de la série Instinct MI350, des performances d’inférence jusqu’à 35 fois supérieures !

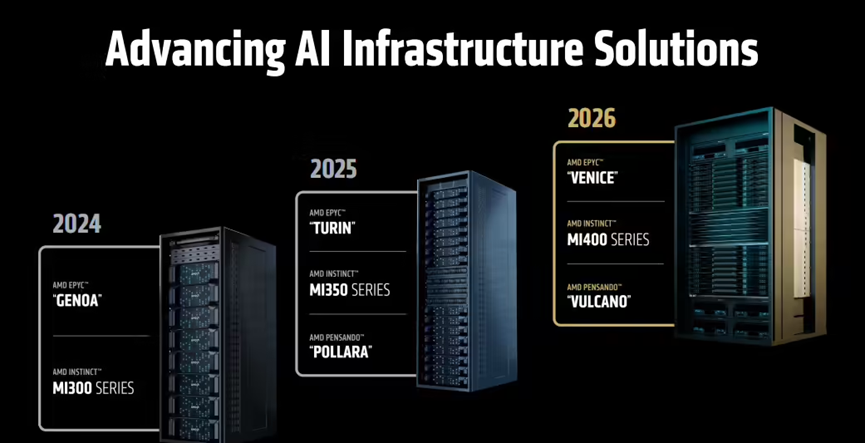

Le 13 juin 2025, AMD a tenu son événement annuel majeur, Advancing AI 2025, avec la participation de sa PDG, la Dre Lisa Su, ainsi que des cadres dirigeants, partenaires de l’écosystème et développeurs. L’objectif : dévoiler les dernières avancées d’AMD dans l’intelligence artificielle (IA) et le calcul haute performance (HPC).

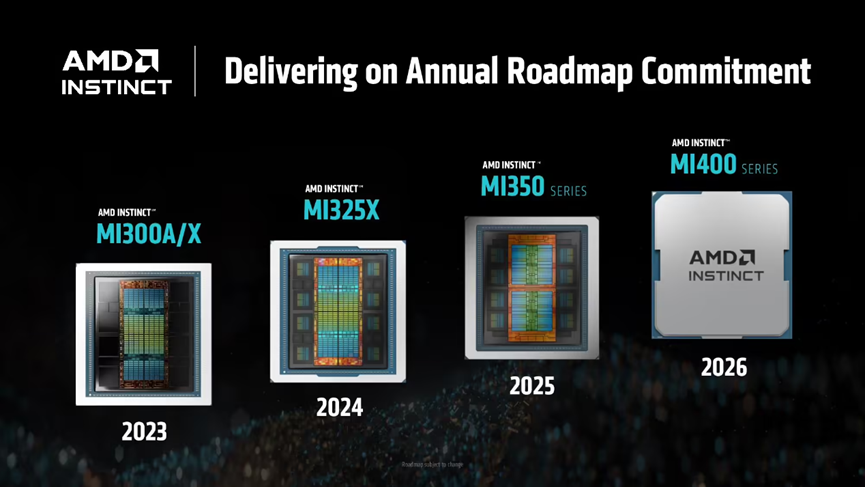

La série GPU AMD Instinct MI350 : une nouvelle ère pour l’inférence IA

La vedette de cette conférence était sans aucun doute la nouvelle génération de GPU AMD Instinct MI350, incluant le modèle phare MI355X. Conçus sur l’architecture CDNA 4 et gravés en 3 nm, ces GPU IA comptent 185 milliards de transistors, marquant un bond technologique majeur.

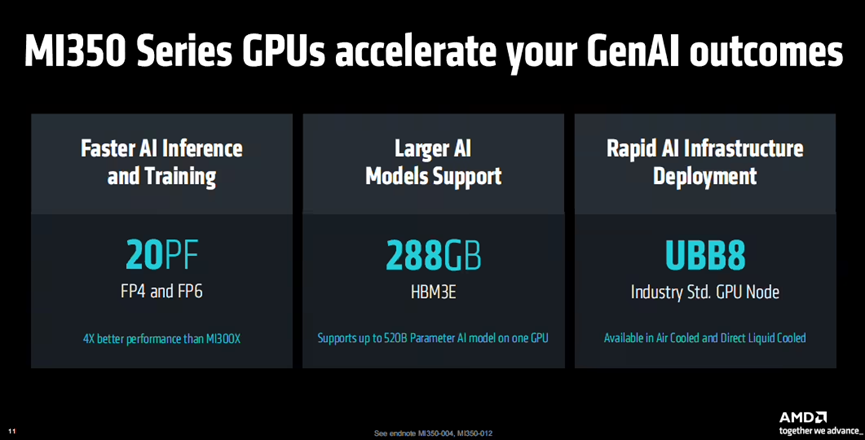

Caractéristiques techniques clés :

- Mémoire : 288 Go de HBM3E

- Taille de modèle IA supportée : jusqu’à 520 milliards de paramètres (520B) sur un seul GPU

- Précisions IA prises en charge : FP4, FP6, FP8, FP16

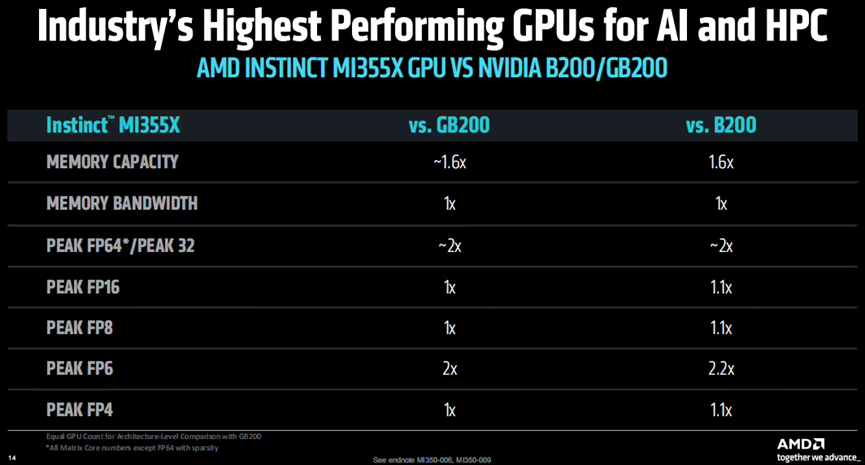

- Performances de pointe :

- FP64/FP32 : 2× plus rapide que les concurrents

- FP6 : plus de 2× supérieur

- FP4/FP8/FP16 : performances égales ou légèrement meilleures

- Efficacité économique : Tokens/\$ 40 % supérieur à celui du NVIDIA B200

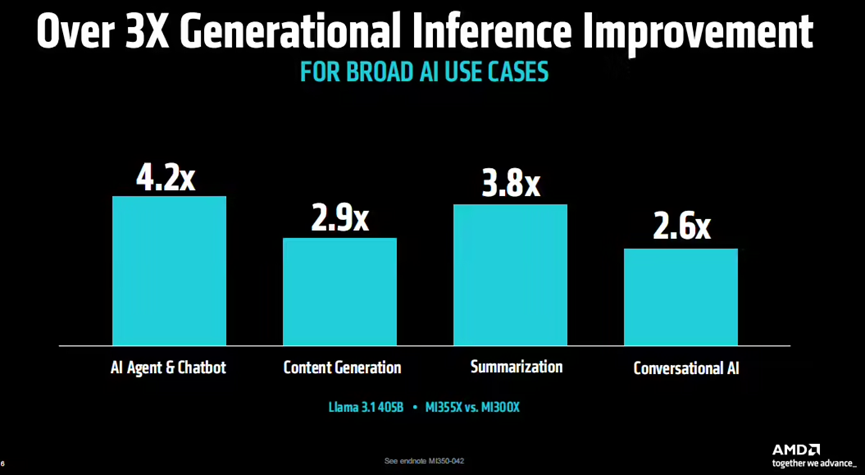

Résultats concrets (test avec Llama 3.1 - 405B) :

- Performance des agents IA : 4,2 × supérieure à la MI300X

- Génération de contenu : 2,9 × plus rapide

- Résumé automatique : 3,8 × plus performant

- Chat conversationnel : 2,6 × plus efficace

Plus impressionnant encore : la série MI350 atteint déjà un gain énergétique de 38×, dépassant l’objectif initial de 30× fixé sur cinq ans.

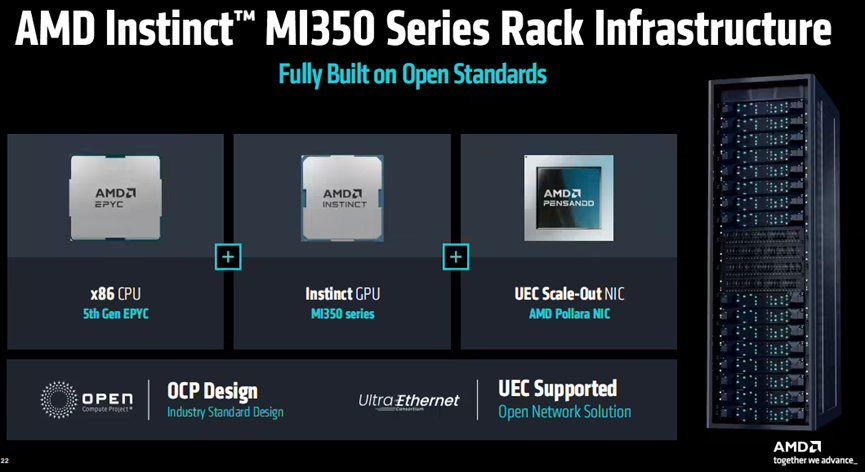

Une infrastructure IA ouverte et évolutive

Les GPU de la série Instinct MI350 sont compatibles avec les standards ouverts UEC et OCP, permettant une architecture IA modulaire et à grande échelle. Trois configurations système sont proposées :

- 128 GPU : 36 To de HBM3E

- 96 GPU : 27 To de HBM3E

- 64 GPU : 18 To de HBM3E

Associée aux processeurs AMD EPYC 5e génération, cette plateforme est conçue pour le pré-entraînement, l’inférence et le déploiement de modèles de grande taille, avec support complet des précisions FP4 à FP8. La commercialisation débutera au troisième trimestre 2025.

Avant-première de l’architecture Helios : MI400 GPU + Zen 6 + carte réseau Vulcano

AMD a également présenté sa prochaine génération d’infrastructure IA, nommée Helios, prévue pour 2026. Elle intègrera :

- GPU Instinct MI400 : 432 Go de HBM4, bande passante de 19,6 To/s, performances maximales de 40 PFLOPS (FP4) et 20 PFLOPS (FP8)

- CPU EPYC “Venice” : basé sur l’architecture Zen 6

- Carte réseau Pensando Vulcano : pour une connectivité intelligente ultra-rapide

Helios vise à offrir une infrastructure IA haut débit, interconnectée et écoénergétique, idéale pour les workloads de génération IA de nouvelle génération.

ROCm 7 : un écosystème logiciel renforcé, ouverture du Developer Cloud

En parallèle du matériel, AMD a dévoilé la version 7 de sa suite logicielle open-source ROCm, améliorée en termes de compatibilité, performances et expérience développeur.

Nouveautés de ROCm 7 :

- Support élargi pour les frameworks IA populaires (TensorFlow, PyTorch, etc.)

- Outils complets pour le développement : pilotes, API, bibliothèques accélérées

- Meilleure portabilité entre différentes plateformes matérielles

De plus, AMD a ouvert son Developer Cloud à l’échelle mondiale, permettant aux développeurs et communautés open-source d’accéder à une plateforme cloud pour la création, le test et le déploiement de modèles IA.

Conclusion : AMD se positionne comme un acteur clé dans l’infrastructure IA générative

Avec le lancement de la série Instinct MI350, l’annonce de la plateforme Helios et les améliorations apportées au logiciel ROCm 7, AMD démontre sa stratégie full stack IA.

Grâce à une performance accrue, une efficacité énergétique exceptionnelle et une approche ouverte, AMD se distingue face à NVIDIA et Intel, et pourrait bien devenir le nouveau leader de l’infrastructure IA pour les modèles génératifs.