L’IA contre l’IA ? Quand les outils de détection AIGC pénalisent les vrais étudiants

Alors que l’intelligence artificielle générative (AIGC) comme ChatGPT, Claude ou Gemini devient un outil de plus en plus courant dans le quotidien des étudiants, certaines universités ont décidé de contre-attaquer… avec d'autres intelligences artificielles. C’est ainsi que sont apparus les outils de détection AIGC dans le monde universitaire, capables — en théorie — d’identifier les textes générés par IA.

Mais un problème se pose : ces outils sont-ils fiables ? Et surtout, ne sont-ils pas en train de pénaliser les étudiants les plus sérieux, ceux qui écrivent eux-mêmes leur mémoire ?

Juger l’humain avec une IA : une logique absurde ?

Certaines universités, comme l’Université du Sichuan, imposent désormais des seuils stricts : si un mémoire dépasse 15 à 20 % de contenu "généré par IA", l’étudiant risque tout simplement de ne pas être diplômé.

C’est là qu’un paradoxe inquiétant apparaît : plus vous écrivez bien, avec un style fluide et cohérent, plus vous risquez d’être accusé d’avoir triché… car selon certains algorithmes, “bien écrire” ressemble à du texte produit par IA.

Une question s’impose alors : qu’est-ce qu’un texte “humain” aujourd’hui ? Si seuls les fautes et les maladresses sont considérés comme des preuves d’authenticité, alors sommes-nous en train de juger la compétence comme un crime ?

Zoom technique : comment fonctionnent ces détecteurs AIGC ? Et pourquoi ils échouent

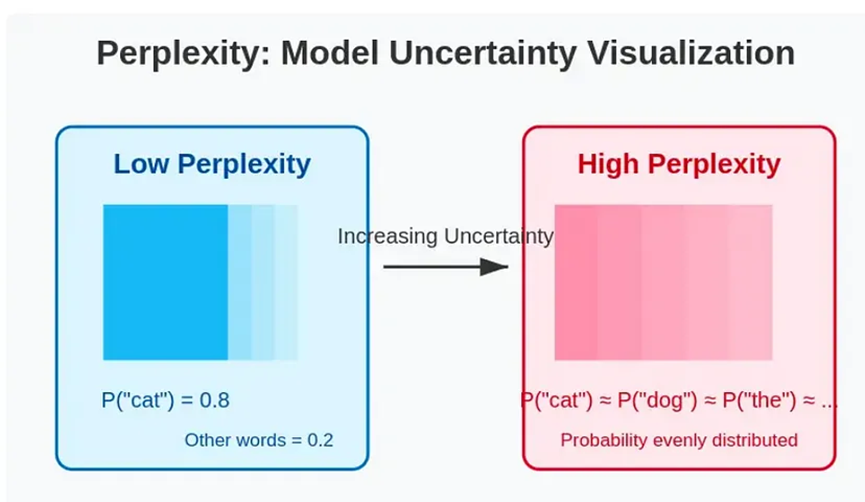

1. Méthode de perplexité et d'entropie

Cette approche mesure la "prévisibilité" du texte. Plus un texte est fluide, plus il est suspecté d’être écrit par une IA. À l’inverse, un étudiant qui s’exprime de manière maladroite sera “validé” comme authentique.

Une analogie : “Si tu réponds bien à une question, on pense que tu as triché. Si tu bafouilles, alors tu es sincère.”

2. Classificateurs de machine learning (boîte noire)

Ces systèmes comparent votre texte à d’énormes bases de données de textes IA et humains, mais leurs critères restent opaques. Une sorte de “tu ressembles à un robot, donc tu en es un”. Un raisonnement biaisé et injuste.

3. Analyse du style et de la structure syntaxique

Longueur des phrases, vocabulaire, tournures trop formelles… Le système identifie des “signaux IA”. Résultat ? Même des chefs-d’œuvre littéraires comme le classique chinois 《滕王阁序》 (“Préface du pavillon du roi Teng”) se voient attribuer un taux de 74 % IA. Absurde, non ?

Une industrie lucrative : mais à qui profite la peur de l’IA ?

Aujourd’hui, des outils puissants comme DeepSeek permettent d’analyser un million de tokens pour moins d’1 euro. Pendant ce temps, des plateformes comme CNKI facturent jusqu’à 2 euros pour 1000 caractères d’analyse.

Ce décalage soulève une autre question : les universités comprennent-elles vraiment la technologie qu’elles imposent ? Ou bien cèdent-elles à la panique technologique au détriment des étudiants ?

Et si on intégrait l’IA dans l’éducation plutôt que de la rejeter ?

Aux États-Unis, certaines universités ont pris une autre voie : elles permettent aux étudiants de former leur propre modèle IA à partir de leurs cours, puis de l’utiliser pour rédiger des essais ou passer des examens. Résultat : une meilleure compréhension de l’outil, une éthique renforcée et des compétences utiles pour le monde professionnel.

Pourquoi ne pas imaginer une matière obligatoire "IA et pensée critique" au même titre que le français ou les mathématiques ?

XXAI : une alternative intelligente et abordable pour les étudiants

La plateforme XXAI intègre les meilleurs modèles du marché (GPT-4o, Claude 3.7, Gemini 2.5, Perplexity, etc.) à un prix ultra-compétitif de seulement 9,9 USD par mois. Avec une seule interface, les étudiants peuvent comparer, générer, corriger ou traduire des textes — en toute transparence.

C’est une façon concrète de rendre l’intelligence artificielle utile, accessible, et respectueuse du travail humain.

Ce n’est pas la faute de l’IA, mais de la manière dont on l’utilise

L’IA ne doit pas devenir un instrument de sanction ou de suspicion. Elle peut (et doit) être un outil d’émancipation intellectuelle. Pour cela, encore faut-il former, expliquer et encadrer, plutôt que punir aveuglément.

En définitive, il ne s’agit pas de lutter contre l’IA, mais d’apprendre à bien s’en servir. Car la vraie question n’est pas : “As-tu utilisé l’IA ?” mais plutôt : “As-tu appris quelque chose en l’utilisant ?”