Quand l'IA fait parler les morts : Justice ou cauchemar éthique ?

Dans une salle d'audience de l'Arizona, un homme décédé a "pris la parole" face à son meurtrier.

« À l'homme qui m'a tiré dessus… J'aurais aimé que nous nous rencontrions dans d'autres circonstances. »

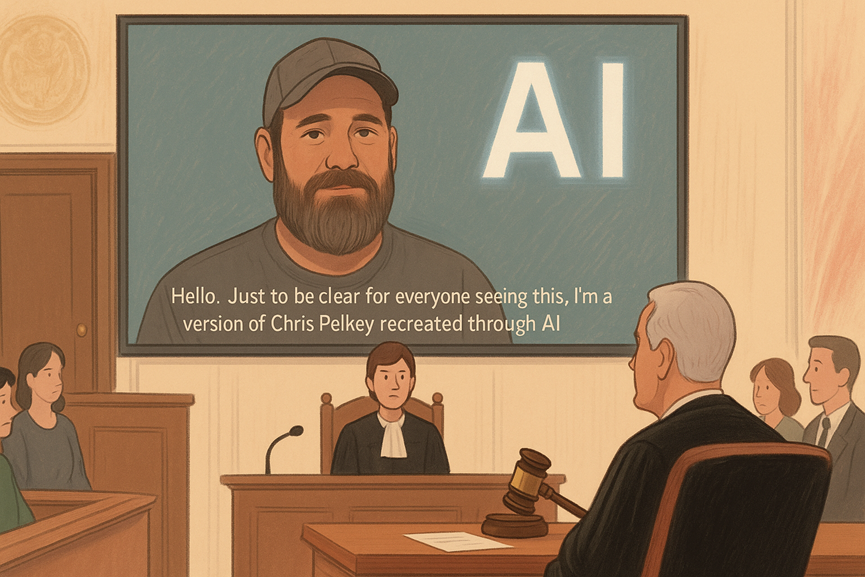

Cette déclaration poignante ne provient ni d'un journal intime ni d'une vidéo enregistrée avant sa mort. Il s'agit d'un deepfake généré par intelligence artificielle, créé par la famille de Chris Pelkey, tué lors d'un incident de rage au volant en 2021. Grâce à des outils tels que Stable Diffusion et LoRA, ils ont ressuscité numériquement Chris pour qu'il délivre un message lors de l'audience de condamnation.

C'est la première fois qu'un témoignage de victime généré par IA est présenté devant un tribunal, marquant potentiellement le début d'une nouvelle ère judiciaire.

Un nouveau type de témoignage

Stacey Wales, sœur de Chris, souhaitait montrer que son frère était plus qu'un nom dans un dossier. En collaboration avec des experts en technologie, elle a utilisé l'IA pour reconstruire son image, sa voix et même ses émotions, basées sur des souvenirs et des conversations avec ses proches.

La vidéo générée par IA a été soumise comme déclaration d'impact de la victime, une pratique courante aux États-Unis permettant aux familles de décrire comment un crime les a affectées. Mais cette fois, la victime "s'est exprimée" elle-même.

Fait surprenant, le juge l'a acceptée.

Indignation et confusion éthique

La réaction ne s'est pas fait attendre.

Pourquoi ?

Parce que ce n'était pas Chris Pelkey qui parlait, mais une approximation générée par machine de ce qu'il aurait pu dire. Cela soulève des questions épineuses :

- Qui décide de ce que les morts auraient voulu dire ?

- Peut-on faire confiance à l'IA pour ne pas déformer ou manipuler ?

- Les futurs tribunaux accepteront-ils les reconstitutions par IA comme "vérité" ?

Certains considèrent la vidéo comme un outil émotionnel puissant. D'autres la jugent manipulatrice et trompeuse — un deepfake déguisé en deuil.

Zones grises juridiques et lignes rouges éthiques

Actuellement, aucune loi n'interdit les déclarations de victimes générées par IA aux États-Unis. Mais cette affaire révèle un vide dans les cadres juridiques et une absence de clarté morale.

Il ne s'agissait que d'une audience de condamnation, sans jury. Mais que se passera-t-il lorsque des témoignages générés par IA apparaîtront lors de procès ?

- L'IA pourrait-elle faire "témoigner" des victimes décédées dans des affaires de meurtre ?

- Une partie pourrait-elle utiliser l'IA pour fabriquer des émotions, et l'autre pour semer le doute ?

La technologie n'est pas neutre

Les outils utilisés pour créer la vidéo étaient open-source et accessibles à tous : Stable Diffusion pour la génération d'images, et des modèles vocaux affinés capables de reproduire la parole de quelqu'un. Les créateurs ont même modifié la barbe et les lunettes de Chris pour correspondre à une version plus "idéale".

Ce qui pose la question : combien de cette vidéo représentait réellement Chris Pelkey, et combien relevait de l'imagination de sa famille ?

À mesure que l'IA évolue, la capacité à simuler des personnes ne fera que s'améliorer. Mais cela signifie également que le risque de manipulation augmente, en particulier dans des contextes émotionnellement sensibles comme les tribunaux.

Quand l'IA rencontre la justice, qui trace la ligne ?

Cette affaire nous oblige à affronter la réalité inconfortable que l'IA redéfinit déjà notre compréhension de la vérité, de la mémoire et de la justice.

Peut-être que l'IA peut offrir une forme de clôture. Peut-être qu'elle peut restaurer la dignité. Mais elle peut aussi déformer, induire en erreur et être mal utilisée.

Et une fois que nous permettons aux morts de "parler", qu'est-ce qui nous empêche de rédiger leurs paroles ?

Réflexions finales : l'IA est déjà là — et plus proche que vous ne le pensez

L'affaire de Chris Pelkey peut sembler extrême, voire dystopique. Mais elle offre un aperçu de ce qui est déjà possible aujourd'hui. L'IA n'est pas une technologie du futur — elle est déjà profondément intégrée dans nos vies.

De l'assistance à l'écriture à la productivité quotidienne, nous dépendons de plus en plus des outils d'IA sans même nous en rendre compte. Et si vous cherchez à explorer la puissance de l'IA de manière pratique et abordable, XXAI est un excellent point de départ.

XXAI regroupe les modèles d'IA les plus avancés — y compris GPT-4o, Claude 3.7, Gemini 2.5, et bien d'autres — sur une plateforme simple d'utilisation. Que vous écriviez, traduisiez, fassiez des recherches ou exploriez simplement les possibilités, XXAI vous donne accès à des outils d'IA puissants à partir de seulement 9,9 €/mois.

L'IA n'est plus réservée aux développeurs et aux entreprises technologiques — elle est pour nous tous. La seule question qui reste est : comment choisirons-nous de l'utiliser ?