Quando a IA julga a IA: estudantes honestos estão sendo punidos por escreverem bem?

Com a popularização de ferramentas como ChatGPT, Claude e Gemini, cada vez mais estudantes usam inteligência artificial (IA) para estudar, organizar ideias ou até revisar seus trabalhos. Em resposta, universidades começaram a adotar detectores de conteúdo gerado por IA para combater o plágio.

Mas esses detectores são realmente confiáveis? Ou será que estamos entrando em uma era onde escrever bem é motivo de punição?

A nova ameaça aos bons alunos: "Você escreve bem demais, deve ser IA"

Universidades como a Universidade de Sichuan, na China, já adotaram políticas que desclassificam TCCs (Trabalhos de Conclusão de Curso) se mais de 15% do conteúdo for considerado “gerado por IA”.

O paradoxo? Quanto melhor for seu português — coeso, claro e elegante — maiores são as chances do sistema acusar seu trabalho de ser artificial. Em outras palavras: se você escreve mal, é humano; se escreve bem, é robô.

É justo punir a competência?

Como funcionam os detectores de IA — e por que eles falham

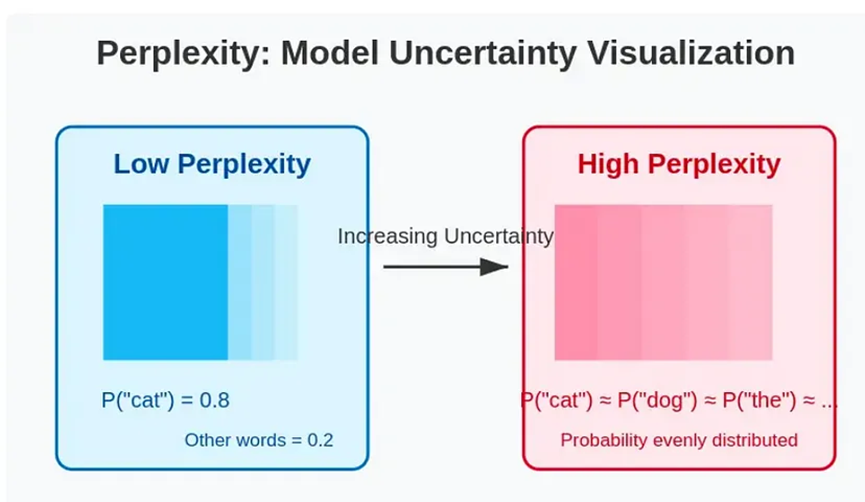

1. Medidas de perplexidade e entropia

Esses métodos medem o quão “previsível” é um texto. Quanto mais fluente, mais suspeito. Isso significa que um aluno que domina bem a língua portuguesa e sabe se expressar pode ser penalizado… por saber escrever.

2. Classificadores treinados com machine learning

Esses sistemas comparam seu texto com grandes bancos de dados de textos escritos por humanos e por IA. Porém, os critérios são opacos. Se o seu estilo parecer com o que a IA geralmente escreve — você está “marcado”.

3. Análise sintática e de estilo

Vocabulário avançado, frases bem estruturadas e ausência de erros gramaticais podem ser considerados “sinais de IA”. Alguns sistemas chegaram a marcar 74% de conteúdo IA em trechos clássicos da literatura chinesa como o texto 《滕王阁序》 — escrito muito antes de qualquer IA existir.

O negócio por trás do medo: quem lucra com a paranoia da IA?

Enquanto ferramentas como DeepSeek conseguem analisar 1 milhão de tokens por menos de 1 real, empresas como a CNKI cobram cerca de 10 reais para verificar 1000 caracteres.

As universidades realmente sabem o que estão usando? Ou estão apenas adotando essas tecnologias por medo — transferindo o risco para os alunos?

E se a IA fosse aliada da educação, e não inimiga?

Em vez de combater a IA com proibições e ferramentas duvidosas, que tal ensinar os alunos a usar IA de forma ética e produtiva?

Nos EUA, algumas universidades já estão permitindo que os alunos treinem seus próprios modelos com os materiais das aulas e os usem em provas ou redações. O foco é no aprendizado, não na punição.

Conheça o XXAI: uma plataforma acessível para estudantes e criadores

A plataforma XXAI integra os melhores modelos de IA do mercado (GPT-4o, Claude 3.7, Gemini 2.5, Perplexity, entre outros) com um plano acessível a partir de US\$ 9,90 por mês. Tudo em uma interface intuitiva, ideal para quem quer estudar, escrever, revisar ou comparar respostas entre diferentes AIs.

Em vez de temer a IA, que tal aprender a aproveitá-la?

A culpa não é da IA, mas de como a usamos

Detectores de IA que punem bons escritores não incentivam a ética — eles apenas promovem o medo e a injustiça.

A verdadeira pergunta que deveríamos fazer não é: "Você usou IA?", mas sim: "Você aprendeu algo no processo?"