Wenn KI gegen KI kämpft – Wie automatische Plagiatserkennung echte Studierende bestraft

Immer mehr Universitäten weltweit setzen auf sogenannte KI-Detektoren, um gegen unrechtmäßige Nutzung von ChatGPT, Claude oder Gemini bei wissenschaftlichen Arbeiten vorzugehen. Ziel ist es, KI-generierte Inhalte in Abschlussarbeiten zu erkennen und Plagiate zu verhindern.

Doch was passiert, wenn diese Systeme nicht die Maschinen, sondern die Menschen bestrafen?

Schreiben wie ein Mensch – aber bitte nicht zu gut

Einige Hochschulen, wie die Universität Sichuan in China, haben konkrete Grenzwerte für den „KI-Anteil“ festgelegt: Liegt dieser laut Detektor über 15–20 %, kann eine Abschlussarbeit abgelehnt werden.

Das Problem: Je besser dein Schreibstil, desto verdächtiger wirkst du. Ein flüssig formulierter Text mit klarer Struktur wird schnell als KI-Verdacht eingestuft. Schreibt man hingegen stockend, mit Rechtschreibfehlern und simpler Wortwahl, gilt man als „authentisch“.

Ist das die neue Definition menschlicher Kreativität?

Wie funktionieren KI-Plagiatserkennungen – und wo liegt der Fehler?

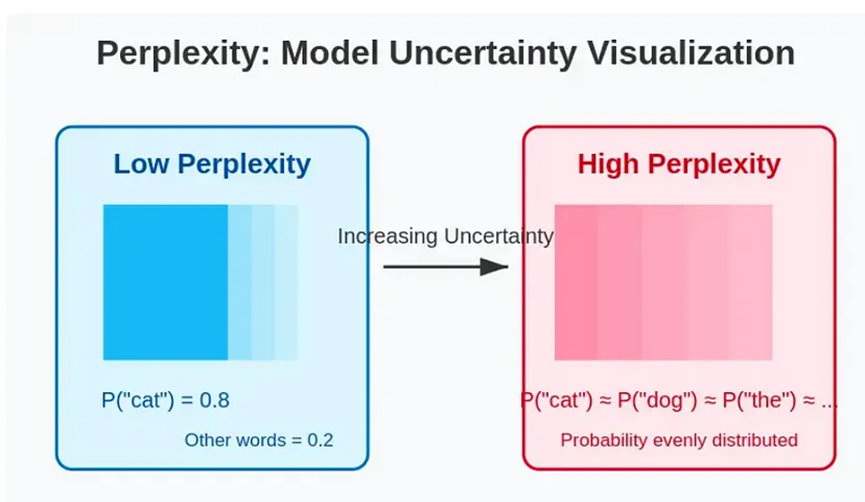

1. Perplexität und Entropie

Ein Maß dafür, wie vorhersehbar oder „zu glatt“ ein Text ist. Hohe Sprachqualität = hohe KI-Wahrscheinlichkeit. Frei nach dem Motto: „Wenn du zu gut schreibst, war’s sicher nicht du.“

2. Klassifikatoren basierend auf maschinellem Lernen

Diese Systeme vergleichen Texte mit großen Trainingsdatenbanken – meist ohne transparente Kriterien. Sie funktionieren wie ein Black Box. Wenn dein Text der „KI-Trainingssprache“ ähnelt, bist du verdächtig.

Ein Vergleich aus dem Alltag: „Du siehst aus wie mein Ex – also musst du genauso schlimm sein.“

3. Stilometrische Analyse

Merkmale wie Satzlänge, Wortwahl oder die Häufigkeit bestimmter Ausdrücke werden bewertet. Das Problem: Auch klassische Literatur oder geübte Autoren weisen diese Merkmale auf.

Ein besonders absurdes Beispiel: Ein chinesischer Klassiker aus dem 7. Jahrhundert wurde von einem Detektor zu 74 % als „KI-generiert“ eingestuft.

Wer verdient eigentlich am KI-Wahnsinn?

Während Plattformen wie DeepSeek Millionen Token für wenige Cent analysieren, verlangen Anbieter wie CNKI umgerechnet 2 Euro pro 1000 Zeichen.

Wer profitiert von dieser neuen Prüfungsbürokratie? Und wissen die Hochschulen wirklich, wie diese Tools funktionieren – oder verlassen sie sich blind auf ein Ergebnis?

Warum nicht mit KI arbeiten statt dagegen?

Statt Studierende unter Generalverdacht zu stellen, könnten Universitäten sie lieber dazu befähigen, verantwortungsvoll mit KI zu arbeiten. In den USA gibt es bereits Hochschulen, die Studierende eigene KI-Modelle mit Fachinhalten trainieren lassen. Diese werden dann für Hausarbeiten oder Prüfungen verwendet.

Eine kreative und nachhaltige Lösung – die Bildung statt Misstrauen fördert.

XXAI: Eine erschwingliche Lösung für verantwortungsvollen KI-Einsatz

Die Plattform XXAI bietet Zugriff auf führende Sprachmodelle wie GPT-4o, Claude 3.7, Gemini 2.5 oder Perplexity – zu einem Preis ab nur 9,90 US-Dollar im Monat. Damit wird der Zugang zu leistungsstarker KI für Studierende und Kreative weltweit erschwinglich.

Ob beim Lernen, Recherchieren oder Schreiben: Mit XXAI bleibt die Kontrolle beim Menschen – nicht beim Algorithmus.

Fazit: Nicht die KI ist das Problem, sondern unser Umgang damit

Automatische Systeme zur KI-Erkennung in Abschlussarbeiten können sinnvoll sein – wenn sie transparent und fair funktionieren. Derzeit jedoch drohen sie, gerade die zu bestrafen, die sich Mühe geben und strukturiert denken.

Vielleicht sollten wir die Frage ändern: Nicht „Hast du mit KI gearbeitet?“ – sondern „Was hast du dabei gelernt?“