死者がAIで語る時:正義の革新か、倫理の崩壊か?

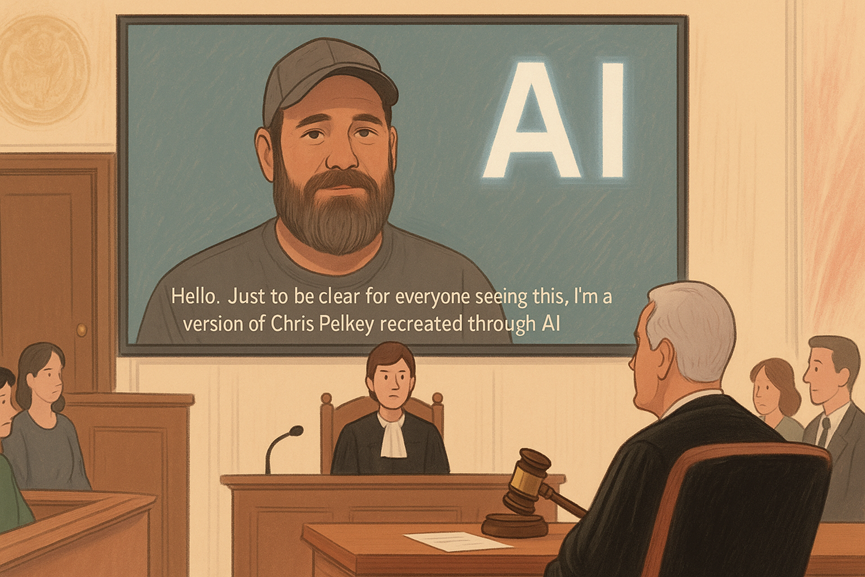

アメリカ・アリゾナ州のある法廷で、すでに亡くなった男性が、自らを殺害した人物にこう語りました。

「私を撃った人へ……できれば、もっと良い形で出会いたかった。」

これは生前に録音された音声でも、書き残した遺書でもありません。 **人工知能によって生成された“ディープフェイク映像”**だったのです。

亡くなったクリス・ペルキー氏は、AI技術により姿と声を「復元」され、殺人犯の量刑を決める法廷で「被害者としての声明」を読み上げました。

これは世界初の「AIで再現された死者の証言」が司法の場で認められた事例となり、瞬く間に世界中の注目を集めました。 そして今、私たちはかつてない問いを突きつけられています:

死者をAIで蘇らせることは、正義を補強するものなのか? それとも、倫理を壊す危険な一歩なのか?

死者の「被害者陳述」がAIで可能に?

クリス氏の姉であるステイシー・ウェールズ氏は、裁判官や陪審員に「弟の人間らしさ」を伝えたくて、このAI映像の作成を依頼しました。

使われたのは、**Stable Diffusion(画像生成AI)**と、LoRA(音声合成モデル)。 家族の記憶、写真、過去のメッセージをもとに、弟の顔や声、さらには話し方や感情表現までも再現したといいます。

このAI被害者声明映像は、加害者であるガブリエル・ホルカシタス被告の量刑判断の場で再生され、裁判官はこれを正式に認めました。

AIで蘇る死者:倫理的なパンドラの箱が開かれる

AI映像が法廷で使用された事実は、アメリカ国内外のメディアで大きく取り上げられ、SNSでも賛否両論が噴出しました。

· 法律の専門家は「陪審員を感情的に誤導する危険がある」と懸念

· AI倫理学者は「これはパンドラの箱だ」と警告

· 一般ユーザーからは「これが許されるなら何でもアリになる」との声

最大の問題は、この映像が**「本人の意思ではない」こと**です。 つまり、あくまで遺族が「こう語ってほしかった」内容をAIが演じているだけで、死者の真意とは限らないのです。

死者の声を“代弁する権利”は、誰にあるのか? AIで蘇った被害者の言葉に、裁判はどこまで影響を受けるのか?

こうした疑問が、今後の司法とAIの在り方を大きく揺るがす可能性があります。

法制度の空白:AI被害者声明にルールなし

現状、アメリカではAIで作成された被害者陳述を禁止する法律は存在しません。 この事件は、急速に進化するAI技術に、法律が追いついていない現実を浮き彫りにしました。

今回のAI映像はあくまで「量刑判断」の参考資料として使われただけですが、今後もし:

· 殺人事件の「証人」や「被害者の証言」がAIで生成されるようになったら?

· 検察がAIを用いて陪審員の感情に訴えるプレゼンを行ったら?

· 弁護側がAI映像の信頼性を疑問視して証拠を無効にしようとしたら?

AIによる「証言の捏造」「感情操作」が法廷で行われる未来は、すでにそこまで来ています。

本当に“本人の声”なのか? AI音声・映像の限界

今回使用されたツールはすべてオープンソースのAIモデル。 Stable Diffusionで顔写真を生成し、音声はLoRAを使って本人の話し方や声質を「学習」させたとのことです。

ただし、実際の映像では:

· 本人のトレードマークだったサングラスを強調

· 髪型や表情を理想化

· セリフの内容は家族の意向を反映

というように、かなりの演出が入っていました。

つまり、私たちが見た「AIクリス」は、どこまで本人なのか? そして、どこからが「他者によって作られたフィクション」なのか?

これが司法現場で許容されるのなら、「何が真実か」の基準自体が崩れるリスクもはらんでいます。

AIと司法の関係性をどう定義すべきか?

この事件が象徴するのは、テクノロジーが「真実」を再構成する時代の到来です。 私たちは今、「亡くなった人がAIで発言する社会」に足を踏み入れようとしています。

もちろん、亡き人を偲びたいという気持ち、また「加害者に思いを届けたい」という願いは理解できます。 しかし、AIは感情を持ちません。倫理も判断しません。 そしてAIで復元された“発言”が、司法判断に影響を与えるならば、その是非は慎重に議論されるべきです。

最後に:AIはツールである。どう使うかは、私たち次第

クリス氏の事件は、極端に見えて実は“遠い未来の話”ではありません。 すでに日本でも、AIによる音声合成、ディープフェイク、文章生成は身近になりつつあります。

例えば、あなたがブログを書いたり、動画の台本を作成したり、翻訳作業をしたりする際に、 ChatGPTやClaude、Gemini、GPT-4などのAIを簡単に使えるツールをお探しであれば、私が今おすすめするのがこちら:

[XXAI(https://xxai.com)/)]

· GPT-4o、Claude 3.7、Gemini 2.5など主要AIを自由に切り替え可能

· AIライティング・翻訳・検索・プロンプト管理など多機能

· 月額たったの9.9ドルから利用可能

AIはもはや専門家だけのものではありません。 誰でも使える時代に大切なのは、「何を目的に、どう使うか」。