AMD Advancing AI 2025: Instinct MI350-Serie revolutioniert KI mit bis zu 35-facher Inferenzleistung

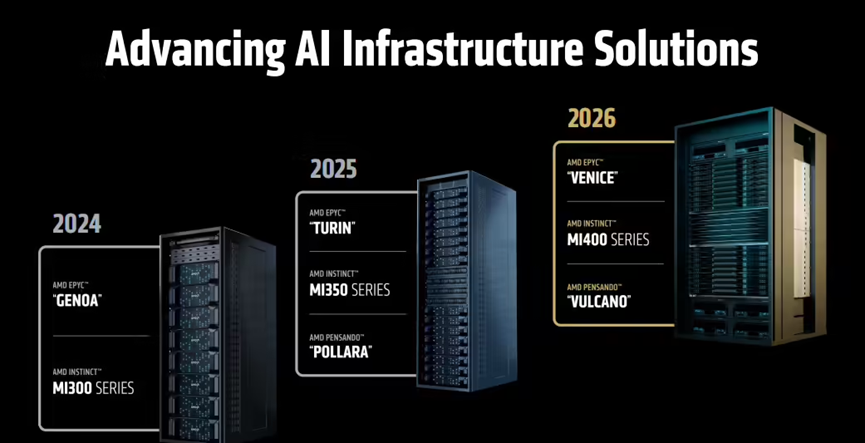

Am 13. Juni 2025 veranstaltete AMD in Peking das jährliche Event Advancing AI 2025, bei dem CEO Dr. Lisa Su gemeinsam mit Führungskräften, Partnern und Entwicklern die neuesten Durchbrüche in den Bereichen Künstliche Intelligenz (KI) und High Performance Computing (HPC) präsentierte.

AMD Instinct MI350-Serie: Neue GPU-Generation mit bahnbrechender KI-Leistung

Das Highlight der Veranstaltung war die Vorstellung der neuen AMD Instinct MI350 GPU-Serie, bestehend aus dem MI350X und dem Flaggschiff MI355X. Diese GPUs basieren auf der neuen CDNA 4 Architektur und werden im fortschrittlichen 3nm-Prozess gefertigt. Mit bis zu 185 Milliarden Transistoren setzen sie neue Maßstäbe.

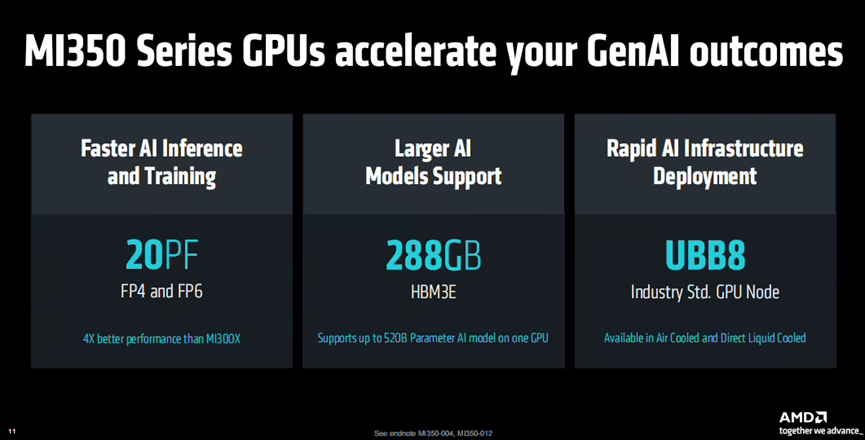

Technische Hauptmerkmale:

- Speicher: 288 GB HBM3E

- Maximal unterstütztes Modell: 520 Milliarden Parameter (520B) auf nur einer GPU

- KI-Präzision: FP4, FP6, FP8, FP16

- Spitzenleistung:

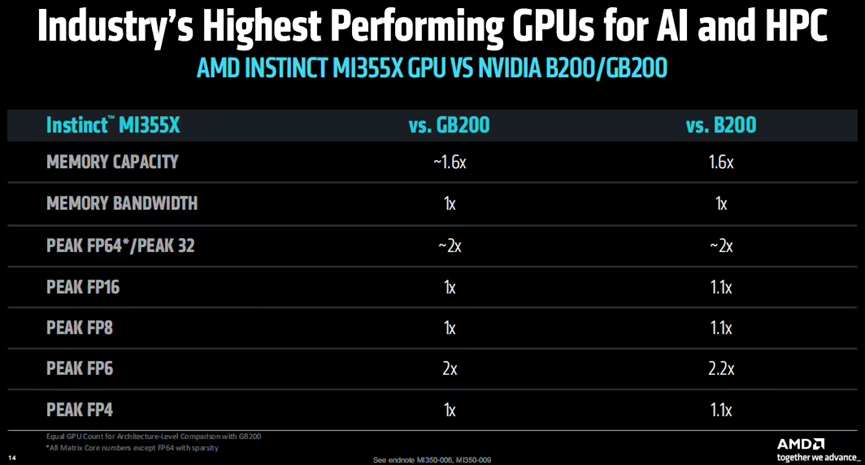

- FP64/FP32: doppelt so hoch wie bei Konkurrenzprodukten

- FP6: über 2x schneller als Wettbewerber

- FP4/FP8/FP16: gleichwertig oder leicht überlegen

- Preis-Leistungs-Verhältnis: 40 % mehr Tokens pro Dollar im Vergleich zur NVIDIA B200

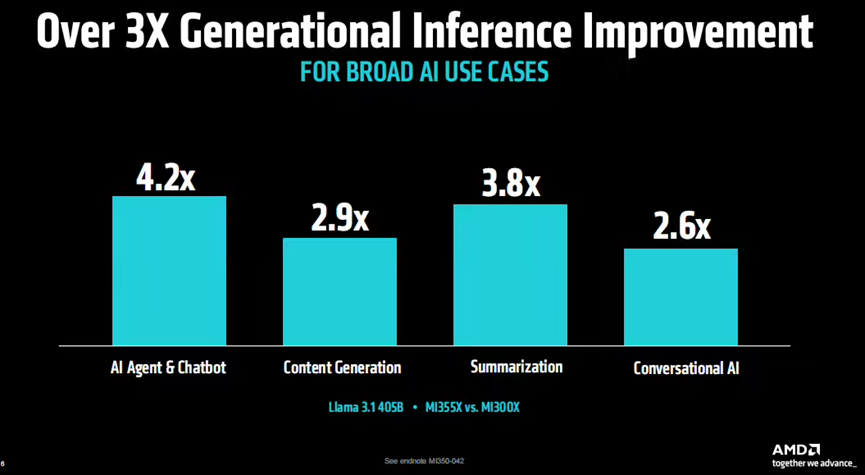

Leistungsdaten beim Llama 3.1 405B Modell:

- KI-Agent-Leistung: 4,2-fach höher als beim MI300X

- Textgenerierung: 2,9-fache Verbesserung

- Zusammenfassungen: 3,8-fache Steigerung

- Dialog-KI-Leistung: 2,6-fach besser

Bemerkenswert ist auch, dass die MI350-Serie bereits jetzt das ursprüngliche Ziel einer 30-fachen Energieeffizienzsteigerung in fünf Jahren übertroffen hat – mit 38-facher Verbesserung.

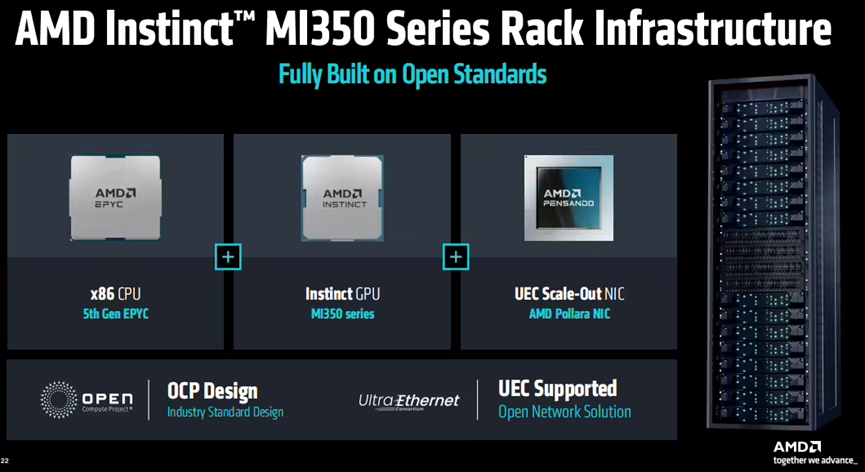

Offene und skalierbare KI-Infrastruktur

Die MI350-Plattform unterstützt offene Standards wie UEC und OCP und bietet eine vollständige End-to-End-KI-Architektur. Sie ermöglicht folgende Großkonfigurationen:

- 128 GPUs: 36 TB HBM3E

- 96 GPUs: 27 TB HBM3E

- 64 GPUs: 18 TB HBM3E

In Kombination mit den AMD EPYC Prozessoren der 5. Generation ist die Plattform ideal für KI-Training, Inferenz und Bereitstellung großer Sprachmodelle, von FP4 bis FP8 Präzision. Die Produkte werden ab dem 3. Quartal 2025 durch Partner weltweit verfügbar sein.

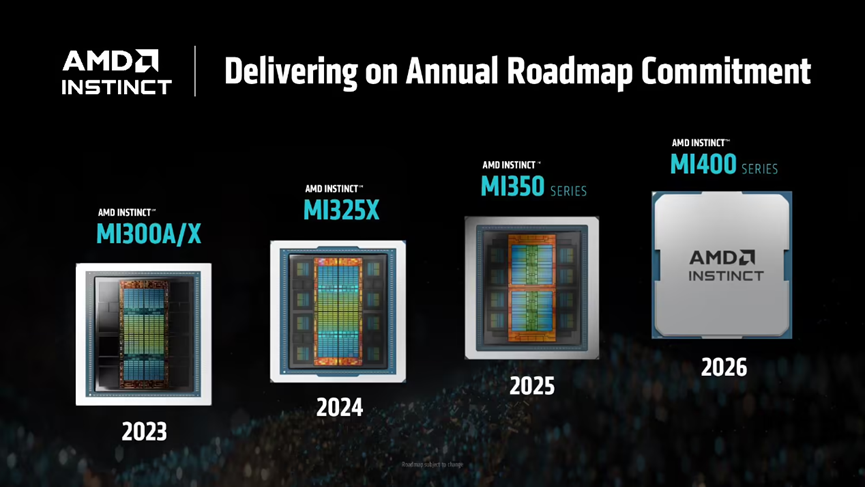

Vorschau auf die nächste Generation: Helios-Architektur für 2026

AMD gab außerdem einen Ausblick auf die kommende Helios KI-Infrastruktur, geplant für 2026. Diese Plattform vereint drei leistungsstarke Komponenten:

- Instinct MI400 GPU: 432 GB HBM4, 19,6 TB/s Speicherbandbreite, bis zu 40 PFLOPS (FP4)

- EPYC “Venice” CPU: Basierend auf der neuen Zen 6 Architektur

- Pensando Vulcano SmartNIC

Die Helios-Architektur soll eine neue Ära der KI mit hoher Bandbreite, Energieeffizienz und Vernetzung einleiten.

ROCm 7: Neue Open-Source-KI-Software und Developer Cloud

Zusätzlich zur Hardware stellte AMD die neue Version des ROCm 7 KI-Software-Stacks vor, mit signifikanten Verbesserungen in Leistung, Kompatibilität und Entwicklerfreundlichkeit.

ROCm 7 Highlights:

- Erweiterte Unterstützung für führende KI-Frameworks (z. B. PyTorch, TensorFlow)

- Umfassendere Toolchains, APIs, Treiber und Bibliotheken

- Verbesserte Hardware-Kompatibilität

Zudem kündigte AMD die vollständige Öffnung der Developer Cloud an, einer gehosteten KI-Entwicklungsplattform für die globale Open-Source-Community – von der Prototypenerstellung bis zur skalierbaren Produktion.

Fazit: AMD positioniert sich als starker Herausforderer in der generativen KI-Infrastruktur

Mit der Einführung der Instinct MI350-Serie, der kommenden Helios-Plattform und dem ROCm 7 Software-Ökosystem untermauert AMD seinen Anspruch, eine führende Rolle im Bereich generativer KI-Infrastrukturen zu übernehmen.

Dank Fokus auf Leistung, Energieeffizienz und Offenheit könnte AMD zur ernsthaften Konkurrenz für NVIDIA und Intel werden – ein potenzieller Gamechanger im globalen KI-Wettrennen.